2013年2月,埃里克·卢米斯(Eric Loomis)在美国威斯康星州的小镇拉克罗斯(La Crosse)开车时被警察拦下。他开的那辆车与一起枪击事件有关,他被逮捕了。最终法院判处他6年监禁。

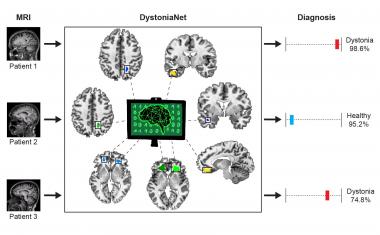

如果不是一项技术帮助法官做出了决定,这可能是一件平淡无奇的案子。他们使用了COMPAS,一种确定被告成为累犯风险的算法。法庭将一系列数据,比如被告的人口统计信息,输入系统,系统就会产生一个分数,显示他们再次犯罪的可能性有多大。

如何算法然而,预测这仍然是不透明的。换句话说,这个方程组是a黑盒——卢米斯在2017年向美国最高法院投诉了这一做法。他声称,COMPAS在做决定时使用了性别和种族数据,并将非裔美国人列为更高的再犯风险。法院最终驳回了他的案子,声称即使没有算法,判决结果也是一样的。然而,也有一些发现表明,COMPAS并不能准确预测再犯。

采用

虽然算法量刑系统已经在美国使用,但在欧洲,它们的采用普遍受到限制。例如,荷兰的一个人工智能量刑系统在媒体批评性报道后于2018年关闭,该系统根据私人案件(如拖欠公司款项)进行判决。然而,人工智能已经进入了欧洲其他领域。它正被推广用于帮助欧洲医生进行诊断新型冠状病毒肺炎.而像英国的M:QUBE这样的初创公司正在迅速涌现,该公司使用人工智能分析抵押贷款申请。

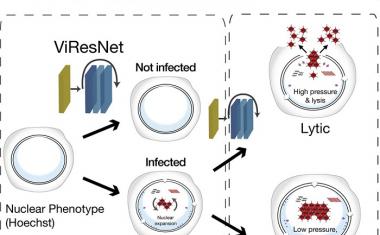

这些系统通过算法运行历史数据,然后得出预测或行动方案。然而,我们常常不知道这样一个系统是如何得出结论的。它可能工作正常,也可能内部存在技术错误。它甚至可能在设计师没有意识到的情况下,复制出某种形式的偏见,如种族主义。

这就是为什么研究人员想要打开这个黑匣子,让人工智能系统变得透明或“可解释”,这一运动现在正在升温。今年早些时候发布的欧盟人工智能白皮书呼吁可解释的人工智能,谷歌和IBM等大公司正在资助对此的研究,GDPR甚至包括了消费者可解释的权利。

位于意大利比萨的国家研究委员会信息科学与技术研究所(Information Science and Technology Institute of the National Research Council)高级研究员福斯卡·詹诺蒂(Fosca Giannotti)说:“我们现在能够生产出在决策方面非常高效的人工智能模型。”“但终端用户往往无法理解这些模型,这就是为什么可解释的人工智能变得如此流行。”

“有时候,即使是设计网络的计算机科学家也不能真正理解其中的逻辑。”

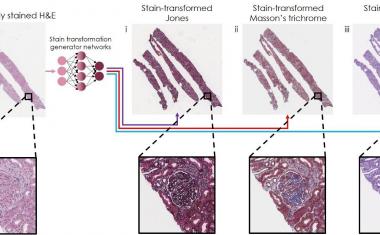

例如,一个系统可以训练大量的人类皮肤的照片,在某些情况下,这代表皮肤癌的症状。基于这些数据,它可以根据皮肤异常的新照片预测某人是否有可能患皮肤癌。这些系统还没有普及,但医院正在越来越多地测试它们,并将它们集成到日常工作中。

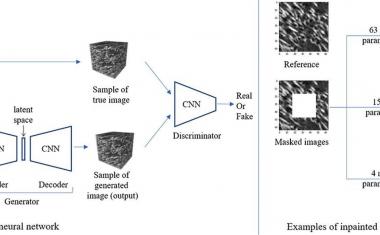

这些系统通常使用一种叫做深度学习,这需要大量的小决定。这些数据被划分成一个网络,层次从几十层到数百层不等,这使得我们尤其难以理解为什么系统会认为某人患有皮肤癌,或者识别错误的推理。

“有时候,即使是设计网络的计算机科学家也不能真正理解其中的逻辑,”詹诺蒂说。

自然语言

对于西班牙圣地亚哥-德孔波斯特拉大学(University of Santiago de Compostela)计算机科学与人工智能教授Senén Barro来说,人工智能不仅应该能够为自己的决定辩护,还应该使用人类语言。巴罗教授表示:“可解释的人工智能不仅要能自然地将结果传达给人类,还要能将结果合理化的推理过程传达给人类。”

他是NL4XAI项目的科学协调员,该项目旨在通过探索不同的子领域,如实现可解释性的特定技术,培训研究人员如何使人工智能系统具有可解释性。他说,最终结果可能看起来像一个聊天机器人。”自然语言技术可以构建对话代理,向人类传达这些互动解释,”他说。

给出解释的另一种方法是让系统提供一个反事实。Giannotti说:“这可能意味着系统提供了一个例子,说明人们需要改变什么来改变解决方案。”在贷款判断算法中,一个反事实可能会向贷款被拒绝的人展示离他们最近的案例是什么,他们将在哪里获得批准。它可能会说某人的工资太低,但如果他们每年多挣1000欧元,他们就符合资格。

白盒子

詹诺蒂说,可解释性主要有两种方法。一种是从无法解释其结果的黑盒算法开始,并找到揭示其内在逻辑的方法。研究人员可以在这个黑匣子系统上附加另一种算法——“解释器”(explator)——它会向黑匣子提出一系列问题,并将结果与它提供的输入进行比较。通过这个过程,解释者可以重建黑匣子系统是如何工作的。

詹诺蒂说:“另一种方法是扔掉黑匣子,使用白盒算法。”这些机器学习系统可以通过设计来解释,但往往不如它们的黑盒对应系统强大。“我们还不能说哪种方法更好,”詹诺蒂警告说。“选择取决于我们正在研究的数据。”当分析非常大量的数据时,比如一个充满高分辨率图像的数据库,通常需要一个黑匣子系统,因为它们更强大。但对于较轻的任务,白盒算法可能会更好。

然而,找到实现可解释性的正确方法仍然是一个大问题。研究人员需要找到技术措施,看看一种解释是否能很好地解释黑箱系统。NL4XAI的Barro教授说:“最大的挑战是定义新的评估方案,以验证生成的解释的良性和有效性。”

“人工智能不会取代人类。它们将被电脑放大。”

最重要的是,可解释性的确切定义有些不明确,这取决于应用它的情况。与使用系统进行医疗诊断的医生相比,编写算法的人工智能研究人员需要一种不同的解释。

“人类(对系统输出的)评价本质上是主观的,因为它取决于与智能机器互动的人的背景,”NL4XAI副协调员、圣地亚哥德孔波斯特拉大学(University of Santiago de Compostela)研究员何塞María阿隆索(Jose María Alonso)博士说。

然而,对可解释人工智能的推动正在逐步推进,这将改善人与机器之间的合作。“人工智能不会取代人类,”詹诺蒂说。“它们将被计算机放大。但解释是合作的重要前提。”

本文由Tom Cassauwers撰写,最初发表于地平线,欧盟研究与创新杂志。

来源:地平线》杂志